В консоли вебмастера Google Search Console появилось сообщение: Индексирование отправленных URL. Разбираемся в причинах и решаем проблему.

Как правило, для ускорения индексации новых материалов на сайте мы запрашиваем переобход роботами Яндекс и Google. Да, теперь не нужно ждать несколько недель следующего визита поисковых роботов. Мы писали об этом здесь.

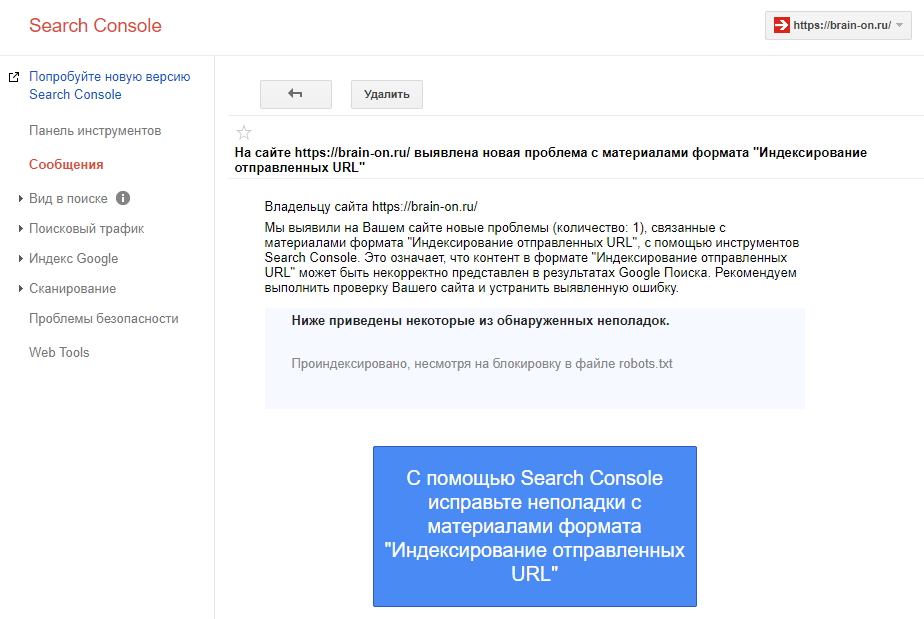

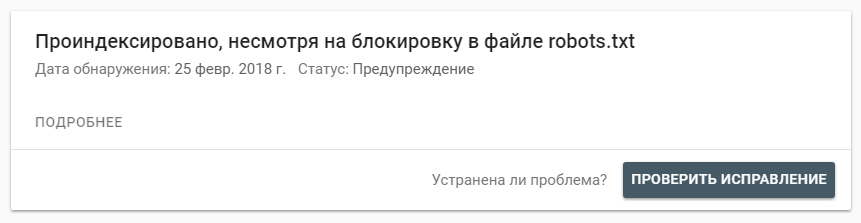

После индексации наших статей мы получили вот такое сообщение в консоли для вебмастера Google:

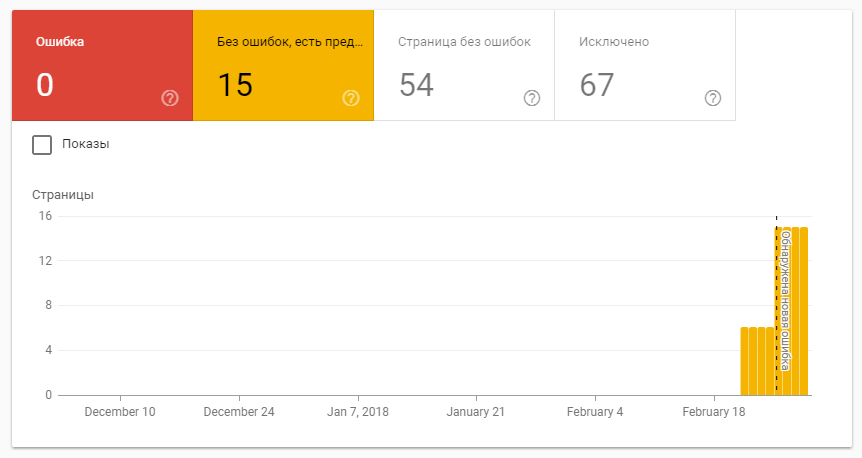

При переходе по ссылке мы видим не ошибки, но предупреждения по индексации:

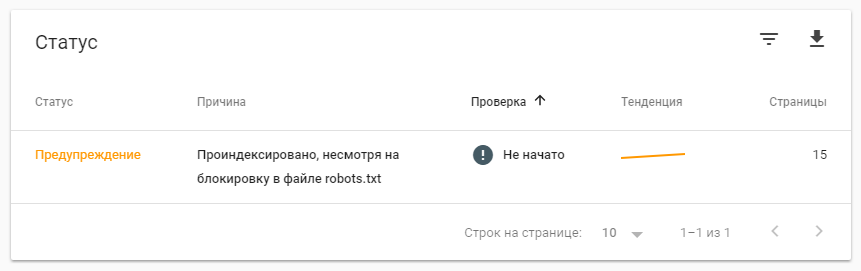

А также статус проблемы, с явно растущей тенденцией:

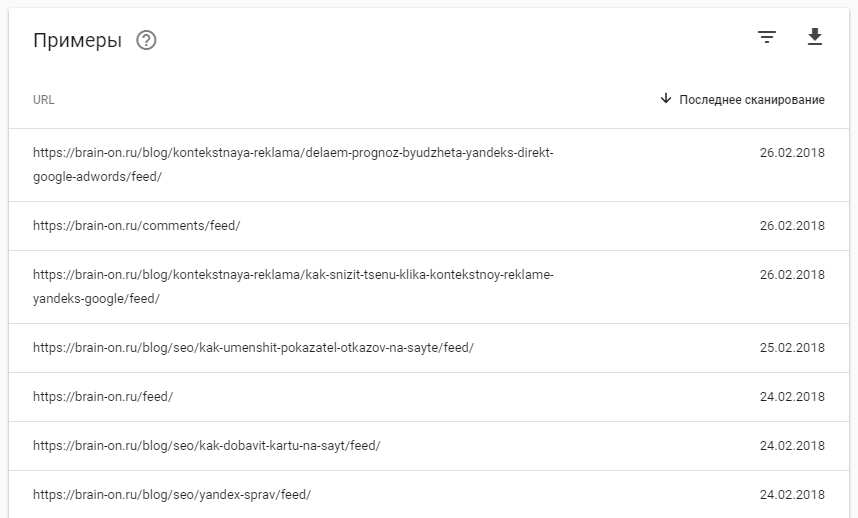

Список страниц, которые конфликтуют между отправкой на индексацию и их запретом в файле robots.txt:

Как видите, это дубли страниц предназначенные для RSS клиентов. Но мы не запрашивали их переобход, что это за страницы и как они попали в индекс. Давайте разбираться.

Суть проблемы

Наш сайт разработан на WordPress и предоставляет RSS-ленту. При просмотре исходного кода в <head> блоке мы видим мета-теги alternate:

|

1

2

3

|

<link rel="alternate" type="application/rss+xml" title="BRAIN-ON! Интернет маркетинг от А до Я » Лента" href="https://seo-ru.com/feed/" />

<link rel="alternate" type="application/rss+xml" title="BRAIN-ON! Интернет маркетинг от А до Я » Лента комментариев" href="https://seo-ru.com/comments/feed/" />

<link rel="alternate" type="application/rss+xml" title="BRAIN-ON! Интернет маркетинг от А до Я » Лента комментариев к «Google Page Speed Insights: разоблачение мифов»" href="https://seo-ru.com/blog/seo/google-page-speed-insights-razoblachenie-mifov/feed/" />

|

В самом же robots.txt была прописана директива «Disallow: */feed*», чтобы убрать возможные дубли из выдачи. Как выяснилось, поисковые роботы воспринимают RSS контент отдельно от обычных страниц и запрещать что-либо нет необходимости.

Решение

В нашем случае помогло простое удаление директивы «Disallow: */feed*» из robots.txt и отправка запроса на повторную проверку:

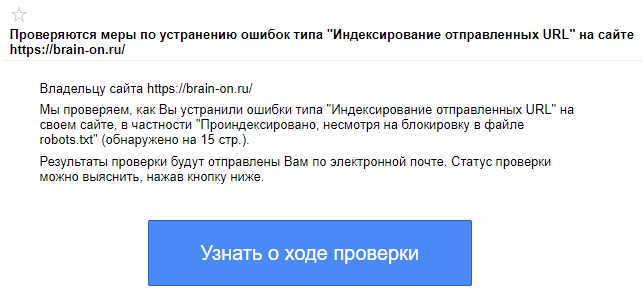

После чего пришло новое сообщение о том, что мы устранили ошибки и после проверки будет выслано письмо на электронную почту с результатами.

Остается немного подождать и эта ошибка исчезнет.

Хорошим тоном будет добавление canonical метатегов во всех alternate материалах. Что позволит явно указать поисковым системам на оригинал, который мы хотим видеть в выдаче.

Выводы

С файлом robots.txt всегда нужно быть внимательным. Можно одной строкой полностью убрать сайт из выдачи, или напротив — сократить количество дублей и поднять его релевантность.

Теги alternate указывают роботу на альтернативную подачу материала страниц и это нужно учитывать. Но не стоит относиться к ним, как к дублям контента.

Сроки и условия

Подписаться

Отчёт